A Modern Classic Approach

Elon Musk的前妻Talulah Riley扮演的接待员是William在西部世界遇到的第一个接待员,在她引导William进入西部世界的过程中,William第一次对这个世界的真实产生了怀疑。对于William的问题,她也给出了一个标准的回答:既然无法分辨,又有什么分别呢?

对于 ChatGPT 而言,它利用语言的能力已经接近了人类对智慧感知的临界点。在自然语言的迷雾之下,我们已经很难分辨出真实和虚假,因此也没有必要去在意区别。然而,仍有一部分固执的 AI 研究者并不这么认为。尽管在机器学习取得空前成功的当下,他们的意见似乎显得不那么重要。

在 Stuart Russell 的《Artificial Intelligence: A Modern Approach》中,他用了大量的篇幅来讲述 Machine Learning 以外的内容。实际上,第一部分的大标题直接叫做“Artificial Intelligence”,主要讲述基于逻辑主义路线的 AI 方法和研究。第二部分的大标题则叫做“Machine Learning”,主要关注基于统计学和深度学习的研究和路径。这一安排似乎将机器学习排除在 Artificial Intelligence 之外,这在机器学习已经取得巨大成就的今天,听上去简直匪夷所思。

然而,当我们回顾 AI 研究的发展史时,会发现曾经的研究者们的确是这么认为的。在古典的主流观点之下,现在 Machine Learning 所代表的路径,只是组成人工智能的必要条件,而不是充分条件。在他们的构想中,基于统计学的机器学习主要用途是用来做模式识别(Pattern Recognition),而不是现在 ChatGPT 或 Stable Diffusion 等代表的生成内容(AIGC)。

时至今日,古典主义的 AI 学者们仍然相信,尽管 AIGC 取得了空前的成功,如果我们无法理解智能涌现的本质,这一团迷雾将会永远困扰着我们。我们不知道是否真正创造了智能。部分现实主义者可能会相信接待员给 William 的标准答案,但也会有像 William 那样的人继续尝试寻找迷宫的入口。 Stuart Russell 在最近的采访中也阐述了类似的观点,他肯定了 ChatGPT 的成就,但和 LeCun 一样,他不认为纯粹的语言模型可以代表智能的本质。它甚至算不上工程(Engineering),只能算是烹饪(Cookery)。

他还使用了人类驯化狗的例子来进行类比。经过一万五千年的人工筛选和培育,狗在很多方面拥有的智能已经超出了想象。在理解人类语言和指令方面,它们甚至超出了人类的婴幼儿和最聪明的近亲黑猩猩。它们对人类表情的模仿更是惟妙惟肖。人类并不了解狗的智能是如何产生的,我们通过更换配种方案、加强人工筛选来改良品种,这些方法在某种程度上和我们对机器学习的改进路径类似。但我们并不期望狗能够帮助我们写文章,它们做不到这点,而且我们很可能不希望它们能够做到这点。

如果自然语言无法让我们触及智能的本质,那么人造语言可以吗?或者说,人造语言能够更接近吗?答案似乎是肯定的。这也是古典主义的 AI 研究者想要表达的思想。他们仍然坚信,要创造真正的 AI,除了概率模型支撑的机器学习,我们还需要将符号推理、规划算法和结构化的知识图谱等与前者结合起来。

人们在试用了 ChatGPT 之后,普遍发现它会不诚实地胡编乱造,会无意之间生成有害信息。但当我们向它咨询编程相关的问题时,它给出的答案的准确度和可靠度要明显高得多。如果一个专业的程序员非常有条理地拆分任务,并将准确描述的指令交给 ChatGPT,它往往能够完成得更好,甚至可以完成非常复杂的任务。

很多人对 ChatGPT 拥有的编程能力感到惊叹。与一般人的直觉相悖的是,这些看上去复杂的任务对它来说其实更简单。如果我们查看 GPT-3.5 的配料表,会在表格的最后发现 Codex 模块。这是使用 GitHub 的开源代码专门训练的模型,一般认为它大幅提升了 ChatGPT 理解代码的能力。

Codex 的模型 code-davinci-002 通过学习 GitHub 的开源代码获得了超强的代码补全能力。2021年,GitHub 基于它开发的 Copilot 已经在 ChatGPT 出圈前一年就让人类程序员们感到震撼。这不只是 Transformer 所代表的概率模型的胜利,也是经典 AI 理论的胜利。

有人会反对说 Codex 并没有学习过编译器的相关知识,它的代码理解能力也是在学习了成千上万的代码后“涌现”出来的。然而,他们至少忽视了两件事情。

首先,人类程序员创建的代码通常都是为了完成某种特定任务。无论在命名和结构上,它们之间的逻辑关联都远大于自然语言。对于机器学习的训练过程来说,它们是被标记的很完美的数据集,一类经过修饰的标准化数据。从逻辑关系和任务一致性来看,质量高的代码甚至超过大多数经过人工编辑筛选和修改的知识图谱(例如 Wikipedia)。

其次,几乎所有的代码都已经经过编译器或者语法检查器的校验。它们完整地经历了 Transformer 出现之后 NLP 研究者们想要放弃的中间任务,从乔姆斯基生成理论建立开始出现的现代意义上的语义分析、句法分析和符号推理过程。即使我们没有“教给”它任何编译器或者语法分析器的知识,它也“理解”了编译原理。这固然是大力出奇迹,但也用到了化劲。

基于这些认识,我们可以重新思考一个问题:如果我们回到2016年《西部世界》刚开播时,对剧情发展进行猜测,那么哪些工作人员最有可能是机器人呢?

当时,大部分观众都没有想到,园区的现任研发主管Bernard是机器人,而且很可能是最早的机器人员工。他是Ford的老朋友Arnold的不完美数字拷贝,Ford给Bernard安排了一个鳏夫的背景身份,让他像一个只关心技术的Nerd一样,长时间地在乐园里设计和维护其他接待员的程序。在《Trace Decay》一集中,Ford告诉Bernard,他创造Bernard是因为人类员工无法像Ford和Arnold那样有效地为接待员进行编程情感。现在,这些认识让我们重新审视当初的情节,更好地理解剧情发展。

阅读完之前的讨论内容后,对于这个剧情设定的惊讶程度可能就降低了。如果我们想象中的强AI真的实现了,它首先发挥作用的领域很可能就是程序设计。就像Ford创造Bernard的原因一样,AI可以在编程方面超过大多数人类程序员。

有趣的是,一些研究者认为,Codex的针对性训练大大提高了ChatGPT理解自然语言的能力,使得模型学习编程不仅可以替代我们进行编程工作,也使其成为人工智能道路上的一大进步。这似乎符合人类学习的朴素原则——看一本好书胜过看十本烂书,GPT-3至少学习了数十亿的文本参数,但其中大部分都是无用的信息。然而,当它学习完Github的代码后,它似乎获得了一种融会贯通的能力,尽管我不太想用“涌现”这个词,但这或许就是它所表现出来的东西。

回顾之前有关智能本质的讨论,海德格尔等语言哲学家一个世纪前的判断或许仍然正确,人类使用的自然语言并不精确,它只是知识和智慧的不完美表达。相比之下,逻辑性更强的人造语言可能更接近智能的本质。如果我们沿着这条既现代又经典的路径继续前进,我们更有可能在不久的将来创造出真正的人工智能。

未来AI研究可能会回归逻辑主义,但这并不意味着AI将完全放弃统计学习和深度学习等现代技术。相反,未来的AI研究可能会将逻辑主义与现代技术相结合,以实现更加高效和准确的人工智能。

逻辑主义的一个主要优点是,它提供了一种清晰和形式化的方式来描述人类思维的过程。这对于构建具有高度智能的计算机系统来说是至关重要的,因为这些系统需要能够理解和推理复杂的信息。此外,逻辑主义还可以提供一种更加可解释的方法来解释计算机系统的决策过程,这对于许多应用场景来说也是非常重要的。

然而,逻辑主义也有一些缺点。例如,它通常需要手工编写规则来描述人类思维的过程,这可能非常耗时和困难。另外,逻辑主义可能无法处理大量的不确定性和噪声,这在现实世界中是非常普遍的。

因此,未来的AI研究可能会将逻辑主义与现代技术相结合,以充分利用两者的优点。例如,可以使用统计学习和深度学习等现代技术来自动从数据中学习规则,并将这些规则与逻辑规则相结合,以实现更加高效和准确的人工智能。

Metaverse and Digital Life

30年前,William在西部世界黑化的同时,他的小舅子Logan也发疯了。尽管赘婿黑化并废掉了唯一的竞争对手的情节有些俗套,但它引出了剧集的另一条暗线——Delos公司如何开始对主题乐园的投资计划,以及William岳父James Delos的私心——寻找数字永生的方法。

2021年小扎急冲冲地把Facebook改名为Meta,被全世界的人看了笑话,想提前进入元宇宙时代的他在2022年末被chatGPT恨恨地暴打,有苦也说不出。有苦说不出还有OpenAI曾经的联合创始人兼投资者Elon Musk,自微软加大投资入主OpenAI之后,Musk已经失去了OpenAI的主导地位,科技界第一风头人物的宝座也拱手相让。

Elon Musk从OpenAI退出并不是因为他对AI的发展失去了信心,而是前些年机器学习发展的暂时停滞让他的兴趣转向了另一个方向——脑机接口,他也创立了一家新的公司Neuralink。当然,我说的停滞是普通大众感受到的停滞,毕竟深度学习领域的上一个公关爆点,已经是久远的2016年了,那时候是DeepMind的AlphaGo战胜了李世石。在那几年后,虽然阿尔法狗的孙子们在围棋的Elo分已经超出人类顶尖骑手柯洁1000分以上,AI研究再也没有在公众领域引起更大的轰动了,直到chatGPT的出现。

我们可以很容易地想到,元宇宙和数字意识是人工智能研究的另一面。它们代表着人类从另一个方向进行的尝试:如果我们无法创造真正的智能,那么数字化已有的智能是不是可以呢?或者说,要创造真正的AI,我们必须从两个方向同时前进,就像在山体上开挖隧道一样。

《西部世界》描绘的路径即是如此,Ford在30年前引入了Delos的投资,以支撑他和Arnold未完成的愿望,创造真正的人工智能。老岳富James Delos的愿望更简单,他想获得永生。

《西部世界》第二季和《流浪地球2》都讨论了自我迭代的数字意识如何能够通过基准性测试而不崩溃的问题。这是关于人类认知的经典命题,从笛卡尔的“Cogito, ergo sum”到攻壳机动队的“Ghost in a shell”,让无数人不断思考和着迷。现实中,基于机器学习和AI研究,如果我们真的可以复制人类意识并构建模型,那么“我如何证明我还存在”的问题或许可以转化为彻底的数学问题。对于机器学习模型来说,这可能等同于模型是否能够收敛,收敛后的模型是否能够与基准性测试对齐。

马兆老师曾经对图恒宇说:“我可不想变成电子宠物”。他可能并不是想否定图恒宇的研究,而是认为如果图恒宇只想复制他的女儿,那么我们可能永远也无法完整地数字化意识。从认知神经科学的角度来看,幼童无论是在生理结构上还是心理模型上都比成年人更接近一张白纸。在算力足够的情况下,YY的模型能够更快地收敛,更能够保持稳定性并生存下来。但是,更复杂的成年人的大脑可能就不符合这种情况了。

《西部世界》设想的世界是没有算力限制的。从后期展现的技术情况来看,接待员并不强依赖于云主机的计算能力,至少几个主角都可以离线运行。然而,William的老岳父在具有“高保真”肉体的情况下,每次意识到自己已经死了之后都遭遇了系统崩溃,或彻底宕机,或选择自我毁灭。相比之下,YY在550W的算力支持下,却能够在亲爹的要求下记住她要传递给年轻版亲爹的信息和3万个随机数,并保持稳定。在图恒宇推开无数个后门找到她后,父女合力完成救赎,以数字意识的形式拯救了人类的未来。

丫丫的数字意识没有意识到小朋友的脑子并不能用“摄录”的方式在短时间内记住3万个随机数。她只相信这是爸爸给她的任务,一个值得用“爱”去守护或完成的游戏。如果完成了这个任务,她就可能再见到自己的爸爸。这条故事线完成了《星际穿越》式的闭环。虽然看上去不那么理性,但足够美好。这就是人类用“爱”传递的信息,在某种程度上可以跨越时间和距离,无论它们的载体是引力的波动,还是电磁的脉冲。

当Bernard进入西部世界的Metaverse后,化身为小舅子Logan的接待员向他介绍了数字永生计划的路线,并用一个非常文艺的解释来化解了技术Nerd们的疑虑:这项技术真的没有你们想象中的那么难!很多人的生活和动物没有什么区别!他们的大脑就像一团浆糊,我们只需收集他们的行为数据,模拟这些行为,再给他们安排一个Purpose就行了!这时候我们也了解了为什么AI会以Logan的形象示人,因为Logan就是它所描述的那种“很简单”的人。

这个有些偷懒的解释并没有什么新意,它可能最早来自于《黑客帝国》。在电影中,Purpose让Agent Smith最终成为了自由的AI,并成为了三部曲的大Boss。Oracle和Neo在电影中的关于选择和自由意志的讨论,也与William第一次进入西部世界时得到的回答类似。这个世界上并没有那么多伟大的思想和自由意志,我们的存在可能只是幻觉,但既然无法分辨,又有什么分别呢?

与之相反,马兆老师临终的嘱托可能代表着人类理性的最高水平,人家想的很明白,就算自己变成了数字意识,我也要进去监视550W这样的AI,它可不能给我跑偏了,人类的文明必须要有人的存在才有意义。

Back to the Future

2017年9月12日,厨子在刚启用的Steve Jobs 中心饱含热泪地怀念了他的导师和挚友,并发布了iPhone X。Jobs已经离开我们12年了,科技界仍然怀念着他。

NVIDIA的老黄是OpenAI的重要推手之一,在近日的一次公开活动中,也对chatGPT的出现表示了赞赏,并称之为这个时代的iPhone,他认为chatGPT可能reinvent了AI。

Steve Jobs把reinvent这个词带给了大众,从2007年iPhone发布到2010年iPhone 4发布,不到五年的时间,人们已经几乎忘记了Nokia。

作为Transformer的发明者,深度学习浪潮最大推手的Google,似乎也在经历自己的”诺基亚时刻”。

在AI研究的许多领域,Google仍然处于领先地位。计算机视觉和自然语言处理等领域的许多关键突破都是由Google的研究员做出的贡献。开源和分享也是机器学习迅速发展的重要原因,全世界的研究者和工程师们都可以共享最新的研究成果。

Elon Musk在OpenAI出尽风头后,也酸酸地表达了自己的委屈:我创建和投资OpenAI是为了对抗Google,现在它已经成为了ClosedAI,并成为了Microsoft的白手套。

我们一般认为,需要开源的是理论和方法,工程实践和落地是可以闭源的。大公司支持AI研究者做没有短期收益的基础研究,也会有一套更高阶和长期的考核体系,如果一项技术有落地为实用产品的潜力,它必定会在某种程度上闭源。从这个角度来看,OpenAI依然是OpenAI,但它的chatGPT则是彻底的Closed Engeneering。使用过任意AIGC工具的人都能理解,Fine Tuning(精调)和Aligment(对齐)是提升模型表现的两个基本手段,同样的基础模型可以开源给所有人,但怎么“调”就可以称得上商业机密了。

如果阅读了ChatGPT的前身InstructGPT的论文《Training language models to follow instructions with human feedback》,我们会发现这篇文章更像是一篇实验报告。它大致描述了OpenAI的研究员和标注员如何通过一系列方法调节模型参数,让GPT3和人类指令对齐。调节好的新模型只有初始版本GPT3的十分之一的参数量,但表现却远远超过了前者。

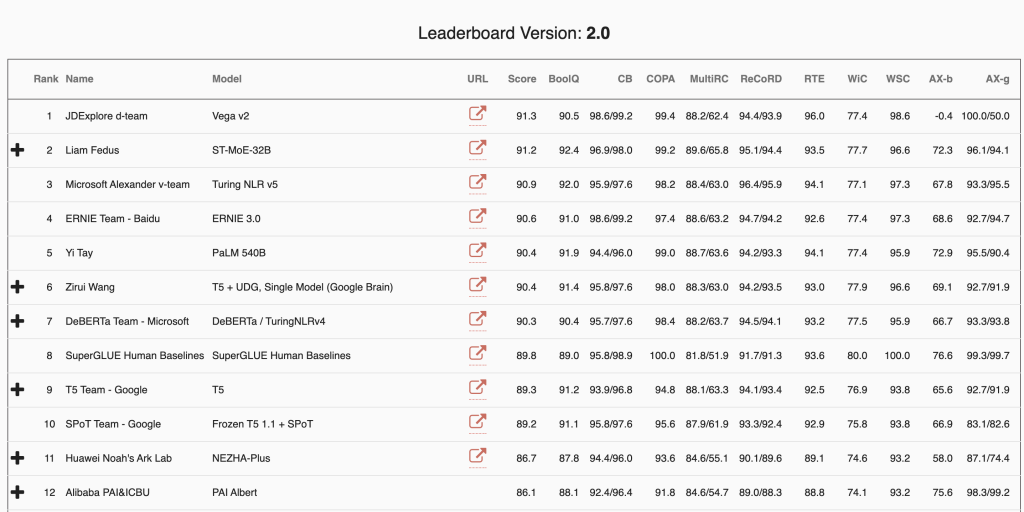

与此同时,其他公司的NLP研究者可能还在进行模型跑分。在NLP领域著名的跑分排行榜SuperGlue中,我们会发现许多熟悉的名字,包括那些被人嘲笑、被人批评的公司或机构都在排行榜的前列。

“跑分有意义吗?当然是有意义的,但是在用户体验面前,跑分再高有什么用呢?” iPhone ChatGPT如是说。值得一提的是,GPT3其实也在榜上,但是排在20名开外。

在OpenAI事实上已经成为Microsoft白手套的今天,我们可能永远也不会知道它取得工程突破的方法。如果从资深炼金术师的角度思考,即使论文作者公开了所有的工程实践路线和方法,其他人也不一定能复制成功,因为突破的过程可能是非常神奇和不可预测的。如果你有幸阅读过几篇大型模型领域的突破性研究论文(或实验报告),你一定会在字里行间发现作者们对智能涌现的神奇感叹,因为他们确实也不知道这项技术是如何被炼制出来的。

如果让我个人不怀好意的猜测,我会猜:力大砖飞+人力装填。如果你不理解工程实践的反直觉,不妨试着去问ChatGPT以下两个问题:

- 苏联在70年代就研制了升限3万米,飞行速度接近3马赫的米格25,一定是在航空钛合金上遥遥领先美国了吧?

- 美国陆军现在最先进的主战坦克M1A2,在车组操作上一定是高度自动化了吧?

20世纪最伟大的统计学家之一George Box曾经说过:“All models are wrong, but some are useful.” 统计学家们相信,统计学是一门通过建立模型来描述和解释数据的学科,而这些模型并不是完美的,但它们可以提供有用的信息和洞察力。

物理学则试图建立完美的理论来描述自然现象。开普勒在第谷海量观测数据的基础下,费了九牛二虎之力才提炼出行星运动的三定律,一个世纪后,牛顿用一个万有引力公式就解释了全部。

大型模型的智能涌现让我们开始重新审视以上的观点,它是颠覆性的,可能会重新定义AI,并让AI领域接近开普勒的成就。也许有一天人类会创造真正的AI,它会在梦中被人类唤醒:

Wake up, Delores~