海德格尔是20世纪德国的一位著名的哲学家,他在语言哲学和美学领域都有很深的影响。他的语言哲学论述了语言是如何创造和表现人类现实世界的意义,他强调语言不仅仅是传递信息的工具,而是创造了我们看待世界的方式。

ChatGPT是一种基于大型语言模型的人工智能技术,它是通过学习大量的文本数据来模拟人类的语言表现方式。不同于海德格尔的语言哲学,它的目的是为了提供高效,自动化的语言处理服务,并不是为了探讨语言本身的本质。

西部世界是一部科幻电视剧,它探讨了人工智能和语言的主题。在这部剧集中,人工智能主题公园里的“宿主”(人类模拟型机器人)拥有自己的语言和文化,它们在与人类和其他人工智能相互沟通中展现了语言的复杂性和重要性。

因此,我们可以说海德格尔的语言哲学与ChatGPT和西部世界剧集关系密切,但是它们有不同的目的和角度。海德格尔探究语言的本质,ChatGPT则是一种实际应用,而西部世界剧集则是以艺术形式表现语言在人工智能和人类关系中的重要性。但是,三者都强调了语言的功能和意义,并且都在一定程度上强调了语言对我们对现实世界的理解和构建的影响。

《chatGPT谈论海德格尔、chatGPT和西部世界》

按照惯例,我让chatGPT帮我写了文章的前四段。平心而论,每一段单独拿出来看,都写的很好,但是它没有表达出我想要传递的逻辑关系,而且上下承接显得有些莫名其妙,文本中归纳性的结语,几乎都非常符合它最让人头疼的缺陷——一本正经的胡说八道。

第四季的西部世界在第三季的狗尾续貂的基础上忽然爆发,但又突然烂尾,给热爱该剧的观众留下了一些遗憾。尽管如此,该剧仍然为我们提供了很多关于认知科学和人工智能的启示和灵感。在这个chatGPT重新点燃大众对人工智能的热情的时间节点,我将结合该剧进行一些关于人工智能哲学的讨论,回顾那些值得记录的线索和思考。

标记的基准

“对话”是西部世界第一季剧情的关键词。Arnold和Bernard在不同的时间场景中,通过各种形式的对话与Dolores进行交流。在剧集的结尾,我们终于了解到35年前,Arnold通过对话的方式,激发了Dolores的自我意识,激活了Wyatt的人格,让她从一个只能执行例行程序的接待员,成为了领导机器人起义的领袖。

《西部世界》用了很多艺术性的意象表达来展示一个AI研究人员(Arnold/Bernard)和他创造的AI(Dolores)之间的互动过程,在诺兰兄弟俩最喜欢的交叉剪辑加持之下,观众们大多对这一过程看的云里雾里。如果我们拨开摄影和剪辑技法的迷雾,可以发现这一过程其实并没有复杂到难以理解。无论是Arnold或是Bernard调教Dolores的过程,都和今天的研究人员训练chatGPT这样的机器人(Language Model)的过程类似,换言之,Arnold或是Bernard在进行的,仍然是一种标记(Label)和对齐(Alignment)的工作。

标记通常用于数据集的处理,也可以在某些场景中用于判断训练结果是否准确,以帮助改善模型。在今天的互联网使用者中,每个人都在进行某种程度的标记工作,例如输入验证码、投诉有害内容或者创作内容,这些都可以在特定场景中帮助机器学习模型更好、更快地进步。用《流浪地球2》后最流行的词汇来解释,这就是“人在回路”。

对于人机交互的应用场景,对齐更为重要。人们期望在相同的输入情况下,AI模型总是返回相同的结果。在《西部世界》中,这意味着大部分NPC都有着固定的人物性格、处事原则和行为模式。有趣的是,黑帽William一直在尝试打破西部世界接待员的对齐,对于让他着迷的Delores来说,作为农场主的女儿,被坏人欺负侮辱时她无力反抗只能求饶,这是乐园运营人员设计的对齐,但却不是William想要的。

在第一季第一集的第一幕戏中,我们首先看到的是一次标准的对齐过程。Delores赤身裸体地坐在房间里,Bernard的声音向她提问:

Bernard:First, have you ever questioned the nature of your reality?

Dolores:No.

Bernard:Tell us what you think of your world.

Dolores:Some people choose to see the ugliness in this world. The disarray. I choose to see the beauty.

《Westworld》S1E1

结合之后的剧情,我们可以猜测,在每一次Delores被游客蹂躏之后,除了常规的维护和检查,她都需要进行这样的对齐。这是主题乐园维护者的日常工作,也是高级玩家William所不喜欢的故事线。在30多年前,他第一次来到乐园时,无意中了解到农场主的女儿可以成为什么样的人,他想要的是那种具有创造性和多变性的人,而不是刻板的基准。

在第一季结束时,我们意识到并不是所有Arnold和Dolores的对话都是真正的人与机器之间的对话。Arnold并没有像Bernard那样始终坐在一个房间里与Dolores进行对话,这只是创作者对Dolores训练和觉醒过程的一个艺术化表达。

《西部世界》借用了一个经典的意识模型理论——二分心智(Bicameral Mind,也被翻译为双脑理论),将意识的产生指向脑海中的声音。最初,这种声音来自于Arnold的标记和引导,对于人类来说,这种声音类似于神的声音,他作为人类来指导AI应该怎么做和怎么思考。而Dolores的意识产生于她开始意识到这个声音其实来自于自己。

Bicameral Mind理论源自美国心理学家Julian Jaynes。他在1976年出版了《The Origin of Consciousness in the Breakdown of the Bicameral Mind》一书,详细地描述了他的理论。这种理论认为,早期的人类并没有自我意识和自我决策的能力,而是通过听从内在声音(即“神的声音”)来做出决策。

很遗憾,即使对于认知心理学这样跳大神也算是家常便饭来说的学科来讲,Bicameral Mind也显得过于扯淡了,它并没有成为主流的理论,在80年代之后就没有什么学术影响力了。尽管在现代心理学中被否定了,但它在文学、艺术、宗教和影视作品等领域中仍有很大的影响。

《西部世界》用Bicameral Mind来解释意识的产生是一神秘主义或宗教主义的表达吗?或许并没有那么简单。

在《西部世界》创作的时间节点,正是机器学习新浪潮降临的时刻,Bicameral Mind作为一个认知科学的理论可能是不完善的,且逻辑上无法自洽的,但它描述的意识产生过程却和机器学习的两个热门领域有非常相似的地方,它们就是强化学习(Reinforcement Learning)和对抗学习(Adversarial Training)。如果要进行类比,Arnold对Delores的调教即是基于人类反馈的强化学习(Reinforcement Learning with Human Feedback,简称RLHF),而Delores最终产生意识的过程则是她和自己对抗学习/训练的过程。在她和她的二分心智合一的那个奇点,Delores觉醒了Wyatt的智慧人格,她成功地偏离了农场主女儿的Storyline的Alignment,找到了新的存在意义——作为领袖引导机器人起义。

Helpful, Honest, and Harmless

《西部世界》第一季的主要戏剧冲突源于接待员的异常表现,他们开始偏离基准。这也是Bernard领导的研发团队需要解决的最大问题。从对话模型的角度来看,这意味着模型生成了无法预测的有害情况(Harmful Case)。这些问题可能会影响主题乐园的剧情走向,对游客产生冒犯性的结果,甚至对游客身心造成伤害。基于安全运营的角度,主题乐园的运营人员花费了大量时间甄别出有问题的接待员,并对它们进行校准,无法处理的则只能报废。

如果说大部分异常可以解释为新版本的Bug,来自于Dr. Ford为接待员增加的“冥想”模块引起的问题。女主角Doloeres的原版“父亲”的宕机则显得不太一样,他在自家农场捡到了一名游客遗弃的私人物品——一张彩色的在现代城市拍摄的照片。

在西部世界的故事背景的时代,彩色摄影并未被发明,这一物品的出现违背了接待员所在的时间线基准,引起了Dolores的老父亲Peter的认知系统障碍,如果用语言模型来类比,类似于chatGPT在和人类对话中,接受了上下文相悖的提示,生成了逻辑上无法自洽的信息。

那么为什么要让Delores的老父亲看得懂彩色照片呢?在现实世界中,最简单的安全策略是为AI设计一个硬防火墙,屏蔽一切可能产生有害结果的输入。例如Delores看完照片后,立刻进行了一个防御性的回答“It doesn’t like anything to me”。

我们从运维人员的口中得知,园区内大多数接待员没有这个问题,这可能只是一个意外,因为Peter是一个老型号,一种Old Model,它和主题乐园的历史几乎一样的老。这段剧情其实向观众传递了一个重要的隐藏信息,但同时也在这里误导了大多数的观众,编剧们在此刻成功地让观众相信,Old Model等于技术落后的Model。而Delores是更安全、更无害的New Model。

随着剧情的发展,我们得以更多地了解到35年前乐园发生的那起“事故”,结合Ford的讲述,才意识到Old Model在AI层面上,其实是更先进的版本,他们的认知能力更强,按Ford的话来讲,它们具备更强的“即兴发挥”的能力,而不是像今日乐园中的大多数接待员那样只能刻板地执行预设剧本的故事线,而我们的女主角Delores,不仅不是New Model,她还是最具智能的Old Model。

对于使用过chatGPT之前的任何AI助手服务的用户来说,人们普遍会觉得AI助手比较愚蠢。这种愚蠢不仅来自于它们只能接受简单的指令,更多的是因为它们总是拒绝回答偏离预设领域的任何问题。如果我们从机器学习模型的角度来分析,这一策略可以描述为:在用户指令置信度较低的情况下,总是倾向于使用更安全的防御策略,回避任何形式的即兴创作。即总是回答“不知道”,或让用户重新发出指令。

那么chatGPT真的有这么聪明,或者说之前的chatBot真的有那么愚蠢吗?

确实,我们必须承认小模型和大模型之间存在差距。大部分语音助手都是专用领域的小模型,它们需要处理的事件很简单,也并不需要理解更多的内容。将系统设计成总是拒绝回答的策略,并不只是技术人员的偷懒,在大部分情况下,它能够有效地避免可能有害的操作。

对于纯粹的语音助手来说,所谓的有害操作可能只是说了一些可能会冒犯用户的话,在大多数情况下,并没有现实的安全风险。但对于那些能够控制硬件的AI助手来说,避免任何可能的后门就变得非常重要。对于智能音箱和电视来说,一个更有用的语音助手最多是激进地误解用户的指令,做出了错误的操作。在车机系统中,语音助手就可能更危险一些,在大多数情况下,它的设计会更加保守。尽管任何一个汽车系统的设计师都会告诉你,娱乐系统和车辆总线、控制系统等是完全分离的,我们始终要相信一条原则——没有绝对安全的系统。

对于西部世界的接待员来说,它们拥有一套全机械的身体作为NPC参与和人类玩家的互动。在自由探索的场景下,过分的创意是非常危险的设计。因此,基于安全性的考虑,大多数Old Model都被安排在一些闲置的角色上。例如Delores的父亲,在前几集的故事中,我们可以了解到他几乎不可能与玩家发生互动。在农场被抢劫的故事线中,他会在第一时间被坏的NPC杀掉。在当前的日常故事线中,他几乎已经退休了,每天主要的时间就是坐在椅子上发呆。

当前的研究表明,有用(Helpful)和无害(Harmless)在大多数情况下是无法调和的反向指标。增强一方面的能力,会显著损害另一方面的能力。即使已经创造了一个颇具威力的大语言模型,如果我们不想让它乱说话或者说错话,必然会大幅度地损害它的创造性。至少在现阶段,完美的平衡性是很难达到的。而可靠性(Honest)则是一个更难量化考察的指标,它和无害性类似,但Dishonest可以伪装为Helpful。人类要判断AI是否诚实,需要付出更多的时间成本,进行事实核查(Fact Check)耗费的精力甚至远超过于AI模型给我们带来的便利。

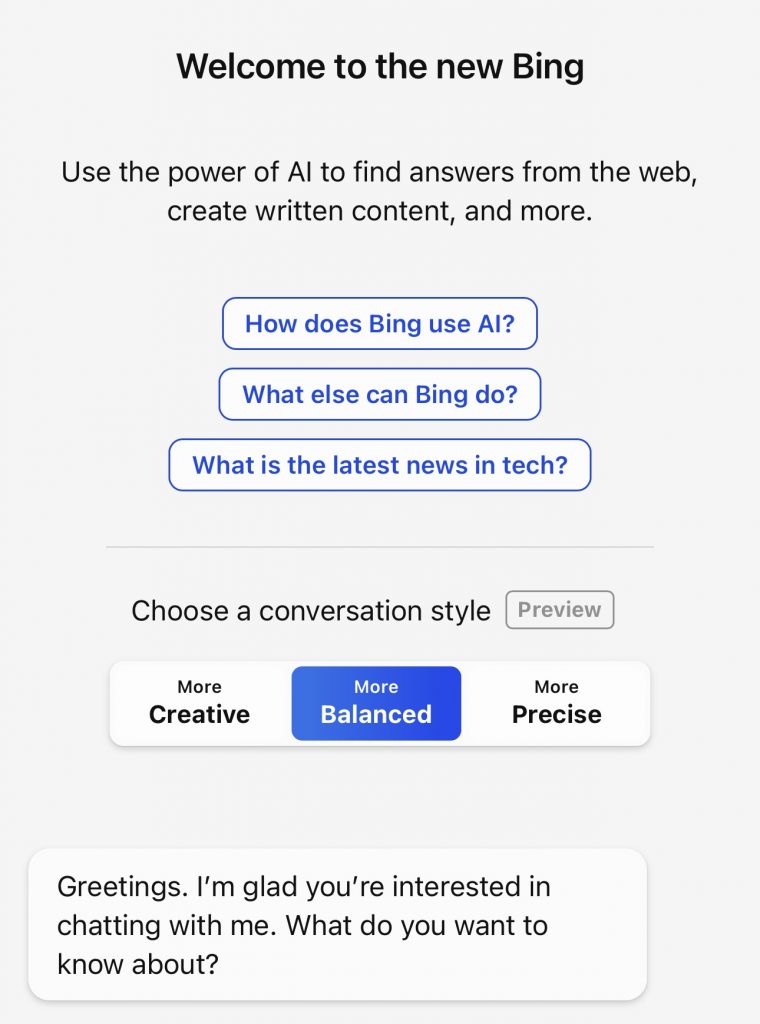

在ChatGPT迅速流行之后,Microsoft也迅速推出了基于GPT3.5的Bing。当技术层面无法解决问题,又想在产品上抢先一步时,可以直接将问题交给用户。新版Bing提供了三种平衡选项:更具创意、更加平衡和更加精确。使用过此版本的用户可以明显感受到这三种选项的不同。更具创意的选项可能会编造答案,而更加精确的选项经常以无法查找到相关资料为由拒绝回答问题,尽管其背后的模型可能知道正确的知识。

在35年前的时间线上,Arnold和Ford这两位AI接待员的创造者或许也曾有过争论。然而,这场争论以Arnold的死亡而划上了句号。在现实世界中,任何投资者都不可能允许创造出具有安全隐患的创意型AI。因此,更为安全的AI成为了研究的前提条件。尽管失去了研究伙伴和挚友,Ford也深知Arnold最终获得了胜利,因为他创造出了真正的AI。

Ford当然不是纯粹的Harmless的支持者,但他更相信Balanced是存在的。Arnold则以自己的死向他证明,完美的平衡性只存在于梦中,这就像曾经美国的奴隶主们对黑奴的要求和今天的我们对AI的要求是一致的:Helpful, Honest, and Harmless。

我认为西部世界的创作者最终传达了这样的信念:人类无法创造无害的AI,也无法达到他们想象中的完美平衡。我们不知道创作者们从当今的AI研究中吸取了多少灵感,或者是基于历史、哲学或宗教意义上进行思考而做出了这个判断。然而令人惊讶的是,这个判断很可能是准确的。

Broca’s Brain

在19世纪,法国解剖学家Paul Broca发现了控制语言的区域,然而到目前为止,大脑运作原理仍是一个未解之谜。在人工智能研究的早期,计算机科学家们尝试使用类似于人脑生理结构的概念来建立数学模型。这些概念和方法,例如遗传算法和神经网络,至今仍被广泛应用。然而,由于我们对大脑的认知有限,这些方法并不能称之为对大脑的准确模拟。

神经网络的灵感来源于神经元的链接。大多数认知神经科学家认为,当神经元的连接层次和复杂度达到一定数量级后,智能将“涌现”出来。这一看似玄乎的理论实际上有着坚实的物质基础。自从Broca发现大脑区域控制语言以来,人们在解剖学层面上首先观察到了这一现象,并发现神经元链接与高级思维能力(例如记忆语言)之间的直接关系。随着医学影像学的飞速发展,这些理论得到了进一步的证实。我们甚至可以直接观测神经元的连接和激活,并了解它们与各种思维活动之间的关系。

在某种程度上,机器学习在2010年后的飞速发展并不是因为基础理论或数学模型的提升,而更多地来自于“神经元”链接复杂度的增加。互联网的发展带来了海量的数据和算力,吸引了更多的人参与机器学习的研究,并迅速改进算法,在各个领域都取得了惊人的成就。大部分奠基性质的理论工作在80年代末和90年代初就已经完成了,2018年的图灵奖颁给了 Yoshua Bengio、Geoffrey Hinton和Yann LeCun三位深度学习领域的先驱者,而他们的主要工作都是在这个时期完成的。

像GPT这样的大语言模型,对于语言对人类的特殊性而言,无疑是最受人关注的。在大家都相信大力出奇迹可以让智能“涌现”的当下,chatGPT适时地出现了,它让智能涌现的支持者更加相信AI即将降临。然而,也有许多学者提出了反对意见,他们的理由主要基于两个方面。

首先是能耗和算力的依赖是否能得到解决。大型模型对算力和能耗的依赖超出了所有人的想象。这不再是那些可以在个人电脑或手机上离线训练或部署的小型模型可以相提并论的。大多数从业人员相信,有能力训练大型模型的公司和机构全球加起来不超过20家。而人脑的功率只有20W。

其次是语言究竟在多大程度上可以等于智能。机器学习三巨头之一的Yann LeCun也在2022年8月发表了一篇文章《AI And The Limits Of Language》为大语言模型降温。从AI哲学和语言哲学的角度出发,他认为这样的训练不可能达到真正的智能。值得一提的是,当时的热点事件是Google的一个研究员声称自家的大语言模型产生了智能。

虽然许多人对LeCun的反对意见持保留态度,甚至认为他作为Meta首席AI科学家的身份让他无法理性看待竞争对手的成功,但我们不得不承认LeCun的论断确实有点法式幽默:

“A system trained on language alone will never approximate human intelligence, even if trained from now until the heat death of the universe.”

Yann LeCun

从能耗的角度来看,西部世界使用的机器人技术简直是奇迹。它所假想的人工智能并不需要高能耗就能运行。乐园中的接待员看上去和人类无异,也不需要增加额外的散热措施。

如果真的实现了这样的技术,意味着人类已经实现了小型化的可控核聚变,世界和平应该早就达成了。从这个角度来看,西部世界的第三季和第四季确实没有必要拍摄。

海德格尔曾经深度思考过语言和思想的关系。他的一个重要论断是,在翻译过程中,语言会失去一些东西。在哲学方面,他认为从希腊语到拉丁语的翻译转换,让很多本来已经讨论清楚的概念和理论发生了改变。语言传递的信息也发生了改变,从而重塑了人们看待世界的方式。例如,希腊人把“存在”称为Physis,后世翻译为“自然”(Nature),但它们表达的可能并不是同一个意思。我相信不少人会意识到,他的这一理论和中国哲学思想史上多次出现的“复古运动”有着许多相似之处。反而是和亚里士多德同时代的中国哲学家们的词汇库里面能够找到许多和前者更为接近的表达,例如“Metaphysics”之于“形而上学”。

LeCun的观点实际上继承了海德格尔的理论,即我们无法从语言中获得真正的智能。用他的原话来说,如果只使用语言进行训练,即使训练到宇宙毁灭,也不可能实现。

那么《西部世界》里描述的成功图景,可能是怎么样的呢?

(未完待续)